Radhad

Erfahrenes Mitglied

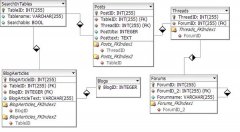

Design einer datenbankgestützten Suchfunktion

Hallo zusammen,

ich überlege derzeit, wie man eine Suchfunktion am besten umsetzen könnte auf einer eigenen Webseite. Die Suchfunktion müsste sehr viele verschiedene Tabellen in der Datenbank durchsuchen. Ich Liste mal ein paar Tabellen auf:

- Posts

- News

- NewsComments

- WikiArticles

- BlogArticles

- BlogComments

...

Nun gibt es mehrere Möglichkeiten, wie man eine Suche gestalten kann.

1. Man verwendet eine externe Suchmaschien wie Google. Dies ist recht einfach zu implementieren, hat aber den Nachteil, dass man auf den Webcrawler von Google angewiesen ist und dass nur 1000 Suchanfragen pro Tag erlaubt sind.

2. Man entwickelt einen eigenen Webcrawler, welcher die eigene Seite immer aktuell hält. Wäre aber auch nicht so effizient

3. Man durchsucht "live" die oben stethenden Tabellen. Es gibt eine Tabelle "SearchTables" wo die Tabellen, die durchsucht werden sollen, gespeichert sind, mit einer Eigenschaft, zu welchem "System" wie Forum, Wiki, Blog, sie denn gehören. Die Auflistung könnte dann sortiert nach dem Datum der letzten Änderung erfolgen. Allerdings dürfte der Zusammenbau der Hyperlinks schwierig werden...

Wie kann man so etwas denn gut lösen? Wie sind eure Erfahrungen mit einer großen Suchfunktion? Wie stark werden die Ressourcen des Servers in Anspruch genommen? Wie speichert man am besten die Daten? Vielleicht lässt sich ja hier im Forum eine gute, offene Lösung finden

Gruß Radhad

Hallo zusammen,

ich überlege derzeit, wie man eine Suchfunktion am besten umsetzen könnte auf einer eigenen Webseite. Die Suchfunktion müsste sehr viele verschiedene Tabellen in der Datenbank durchsuchen. Ich Liste mal ein paar Tabellen auf:

- Posts

- News

- NewsComments

- WikiArticles

- BlogArticles

- BlogComments

...

Nun gibt es mehrere Möglichkeiten, wie man eine Suche gestalten kann.

1. Man verwendet eine externe Suchmaschien wie Google. Dies ist recht einfach zu implementieren, hat aber den Nachteil, dass man auf den Webcrawler von Google angewiesen ist und dass nur 1000 Suchanfragen pro Tag erlaubt sind.

2. Man entwickelt einen eigenen Webcrawler, welcher die eigene Seite immer aktuell hält. Wäre aber auch nicht so effizient

3. Man durchsucht "live" die oben stethenden Tabellen. Es gibt eine Tabelle "SearchTables" wo die Tabellen, die durchsucht werden sollen, gespeichert sind, mit einer Eigenschaft, zu welchem "System" wie Forum, Wiki, Blog, sie denn gehören. Die Auflistung könnte dann sortiert nach dem Datum der letzten Änderung erfolgen. Allerdings dürfte der Zusammenbau der Hyperlinks schwierig werden...

Wie kann man so etwas denn gut lösen? Wie sind eure Erfahrungen mit einer großen Suchfunktion? Wie stark werden die Ressourcen des Servers in Anspruch genommen? Wie speichert man am besten die Daten? Vielleicht lässt sich ja hier im Forum eine gute, offene Lösung finden

Gruß Radhad

Zuletzt bearbeitet: